Anthropic nel mirino: accuse di ‘ragazzaia’ di dati da Freelancer e iFixit

La startup di intelligenza artificiale Anthropic, sostenuta da Google, si trova al centro di una controversia per la presunta raccolta non autorizzata di dati da due importanti piattaforme online: Freelancer e iFixit. Entrambe le aziende hanno accusato Anthropic di aver utilizzato i loro contenuti per addestrare i propri modelli di intelligenza artificiale generativa senza il loro consenso.

Secondo Engadget, Freelancer e iFixit affermano che i sistemi automatizzati di Anthropic hanno effettuato milioni di visite ai loro siti, ignorando il file robots.txt, che contiene le istruzioni sulle pagine a cui i sistemi automatizzati possono accedere. Il bot di Anthropic, in particolare, avrebbe visitato 3,5 milioni di pagine di Freelancer in quattro ore e un milione di pagine di iFixit in 24 ore.

Il problema del ‘crawling’ e la questione del copyright

La pratica di utilizzare software “crawler” per raccogliere contenuti da siti web e addestrare modelli di intelligenza artificiale è diffusa nel settore. Tuttavia, questa pratica ha già portato a diverse cause legali da parte degli editori che si sentono lesi nel loro diritto d’autore. OpenAI, ad esempio, ha stipulato accordi con diversi siti web per garantire la legalità della raccolta di informazioni.

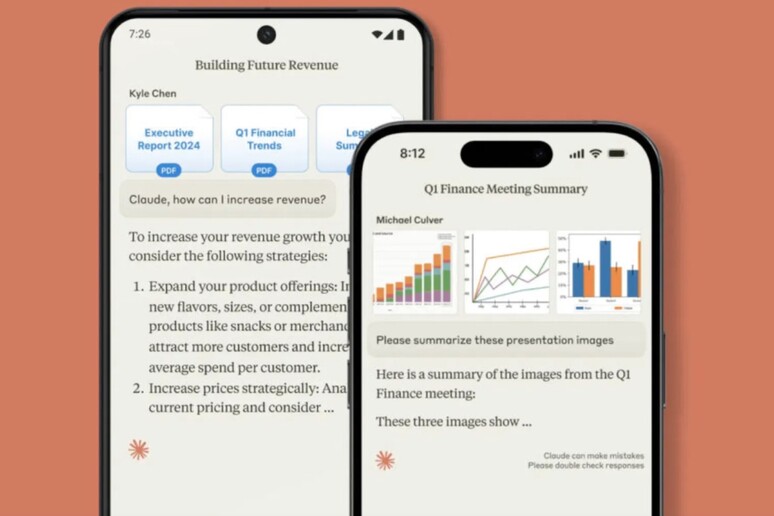

Anthropic, che si è sempre presentata come un’azienda che sviluppa software trasparenti e legittimi, si trova ora a dover affrontare queste accuse. L’azienda ha lanciato il suo chatbot AI, Claude, disponibile anche come app per iOS e Android.

La risposta di Anthropic e le implicazioni per il futuro dell’IA

Anthropic non ha ancora rilasciato una dichiarazione ufficiale in merito alle accuse. Tuttavia, questo caso solleva importanti questioni sull’etica e la trasparenza nell’utilizzo dei dati per l’addestramento dei modelli di intelligenza artificiale. Le aziende che sviluppano soluzioni di intelligenza artificiale devono assicurarsi di rispettare le leggi sul copyright e i diritti degli editori, e di essere trasparenti nei loro metodi di raccolta dati.

La controversia su Anthropic potrebbe avere un impatto significativo sul futuro dell’IA. Se le accuse si rivelassero fondate, potrebbe portare a un maggiore controllo e regolamentazione del settore, con l’obiettivo di garantire un uso responsabile e etico dell’intelligenza artificiale.

Un futuro per l’IA basato sulla trasparenza e l’etica

L’episodio di Anthropic evidenzia la necessità di un approccio più responsabile e trasparente nell’utilizzo dei dati per l’addestramento dei modelli di intelligenza artificiale. Le aziende che operano in questo settore devono impegnarsi a rispettare le leggi sul copyright, a ottenere il consenso degli editori e a rendere pubblici i propri metodi di raccolta dati. Solo in questo modo si potrà garantire un futuro per l’IA basato sulla fiducia e l’etica.