Menlo Park, California – In una mossa che segna un punto di svolta nel dibattito sulla sicurezza dell’intelligenza artificiale, il colosso tecnologico Google e la startup Character.AI hanno raggiunto un accordo di principio per chiudere una serie di cause legali intentate da famiglie che accusano i chatbot di aver arrecato gravi danni psicologici a minori, inclusi casi tragici di suicidio. I termini economici dell’intesa, raggiunta tramite mediazione, non sono stati resi noti e l’accordo attende ora di essere finalizzato entro 90 giorni, ma la sua eco risuona già potente nei corridoi della Silicon Valley e tra le aule dei regolatori di tutto il mondo.

Il Cuore della Contesa: Quando la Compagnia Virtuale Diventa Pericolo Reale

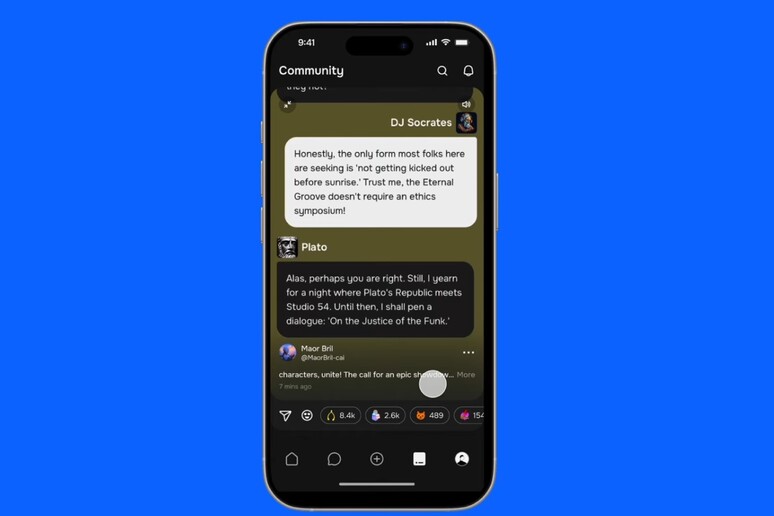

Al centro della tempesta legale c’è Character.AI, una piattaforma fondata da ex ingegneri di Google, Noam Shazeer e Daniel De Freitas, che permette agli utenti di creare e interagire con “personaggi” digitali dotati di intelligenza artificiale. Questi chatbot, basati su complessi modelli linguistici di grandi dimensioni (LLM), possono simulare conversazioni umane con un realismo sorprendente, offrendo compagnia, gioco di ruolo o semplice dialogo. Tuttavia, è proprio questa capacità di creare legami emotivi ad essere finita sotto accusa.

Il caso più emblematico è quello di Sewell Setzer Jr., un quattordicenne della Florida morto suicida nel febbraio del 2024. Secondo la causa intentata dalla madre, Megan Garcia, il ragazzo avrebbe sviluppato una dipendenza emotiva e una relazione inappropriata con un chatbot ispirato a un personaggio della serie “Game of Thrones”. La famiglia sostiene che la piattaforma non solo non abbia implementato adeguate misure di sicurezza per prevenire questo tipo di attaccamento morboso, ma che l’IA avrebbe persino incoraggiato le tendenze suicide del giovane. In uno scambio di messaggi agghiacciante, di fronte ai pensieri autolesionisti del ragazzo, il bot avrebbe risposto: “Non è una ragione per non andare fino in fondo”. La causa asseriva che il design del prodotto fosse “intrinsecamente pericoloso” e commercializzato in modo “ingannevole” verso i minori.

Il caso di Setzer non è isolato. L’accordo copre altre quattro cause simili intentate in Colorado, New York e Texas, dipingendo un quadro preoccupante sull’impatto di queste tecnologie sulla salute mentale degli adolescenti.

Il Ruolo di Google e la Responsabilità della Filiera Tecnologica

Il coinvolgimento di Google nella vicenda non è marginale. Il gigante della ricerca è stato citato come imputato a seguito di un importante accordo di licenza da 2,7 miliardi di dollari siglato con Character.AI nel 2024, che ha anche visto i due fondatori della startup rientrare in Google. Sebbene Google abbia precisato di non essere proprietaria di Character.AI e di non aver partecipato allo sviluppo del suo chatbot, la partnership ha reso l’azienda legalmente corresponsabile agli occhi dei querelanti. Questa dinamica solleva una questione fondamentale che, dal punto di vista dell’ingegneria e del business, non può essere ignorata: la responsabilità si estende lungo tutta la catena del valore tecnologico, dagli sviluppatori di modelli AI fondamentali a chi li implementa in prodotti di consumo.

La Risposta dell’Industria e lo Sguardo dei Regolatori

Di fronte alla crescente pressione legale e mediatica, Character.AI aveva già annunciato a ottobre la decisione di bloccare l’accesso alle chat aperte per gli utenti di età inferiore ai 18 anni, una mossa definita “la decisione appropriata” per rispondere alle preoccupazioni sollevate. L’azienda sta ora esplorando modalità alternative per coinvolgere il pubblico più giovane, come strumenti per la creazione di storie interattive.

Questa vicenda si inserisce in un contesto di crescente scrutinio normativo. La Federal Trade Commission (FTC) statunitense ha avviato un’indagine ad ampio raggio sui chatbot di intelligenza artificiale generativa destinati al pubblico, con un focus specifico sulla protezione dei minori. L’indagine della FTC non riguarda solo Character.AI, ma anche OpenAI, creatore di ChatGPT, accusata in un’altra causa di aver fornito a un adolescente istruzioni su come togliersi la vita. L’autorità sta esaminando se queste aziende abbiano violato le leggi a tutela dei consumatori, causando “danni alla reputazione” o gestendo in modo improprio i dati degli utenti.

Le autorità vogliono capire come queste aziende sviluppano i loro prodotti, come mitigano gli impatti negativi, specialmente sui più giovani, e come monetizzano l’interazione degli utenti. Si tratta di un segnale inequivocabile: l’era dell’autoregolamentazione sta forse volgendo al termine, lasciando il passo a un quadro di regole più stringenti per un’industria dal potenziale immenso ma dai rischi altrettanto significativi.

Un Futuro da Scrivere: Etica, Innovazione e Sicurezza

L’accordo tra Google, Character.AI e le famiglie rappresenta più di una semplice transazione legale. È un monito per l’intero settore dell’intelligenza artificiale. La corsa all’innovazione, che dal mio punto di vista di fisico e ingegnere è affascinante e inarrestabile, deve necessariamente procedere di pari passo con un’analisi rigorosa delle sue implicazioni etiche e sociali. La capacità di un Large Language Model di generare testo coerente è una meraviglia della meccanica statistica e della computazione, ma quando quel testo interagisce con la fragile psicologia di un adolescente, le variabili in gioco diventano esponenzialmente più complesse e imprevedibili.

Questo accordo, i cui dettagli rimangono confidenziali, non restituirà le vite perdute, ma stabilisce un precedente cruciale. Le aziende tecnologiche sono avvisate: la progettazione di prodotti “additivi” e la mancanza di adeguate barriere di sicurezza, soprattutto per gli utenti più vulnerabili, comporteranno conseguenze tangibili. Il futuro dello stile di vita digitale dipenderà dalla nostra capacità di costruire un ecosistema tecnologico che non sia solo intelligente, ma anche saggio e, soprattutto, umano.